博文

多聚点子空间下的时空信息融合及其在行为识别中的应用

|

引用本文

杨天金, 侯振杰, 李兴, 梁久祯, 宦娟, 郑纪翔. 多聚点子空间下的时空信息融合及其在行为识别中的应用. 自动化学报, 2022, 48(11): 2823−2835 doi: 10.16383/j.aas.c190327

Yang Tian-Jin, Hou Zhen-Jie, Li Xing, Liang Jiu-Zhen, Huan Juan, Zheng Ji-Xiang. Recognizing action using multi-center subspace learning-based spatial-temporal information fusion. Acta Automatica Sinica, 2022, 48(11): 2823−2835 doi: 10.16383/j.aas.c190327

http://www.aas.net.cn/cn/article/doi/10.16383/j.aas.c190327

关键词

行为识别,信息融合,深度时空图,多聚点子空间学习

摘要

基于深度序列的人体行为识别, 一般通过提取特征图来提高识别精度, 但这类特征图通常存在时序信息缺失的问题. 针对上述问题, 本文提出了一种新的深度图序列表示方式, 即深度时空图(Depth space time maps, DSTM). DSTM降低了特征图的冗余度, 弥补了时序信息缺失的问题. 本文通过融合空间信息占优的深度运动图(Depth motion maps, DMM) 与时序信息占优的DSTM, 进行高精度的人体行为研究, 并提出了多聚点子空间学习(Multi-center subspace learning, MCSL)的多模态数据融合算法. 该算法为各类数据构建多个投影聚点, 以此增大样本的类间距离, 降低了投影目标区域维度. 本文在MSR-Action3D数据集和UTD-MHAD数据集上进行人体行为识别. 最后实验结果表明, 本文方法相较于现有人体行为识别方法有着较高的识别率.

文章导读

人体行为识别是计算机视觉领域和模式识别领域的一个重要的分支, 应用范围十分广泛, 在智能监控、虚拟现实等应用中表现十分优秀[1-5]. 传统的人体行为识别使用的是彩色摄像机[6]生成的RGB图像序列, 而RGB图像受光照、背景、摄像器材的影响很大, 识别稳定性较差.

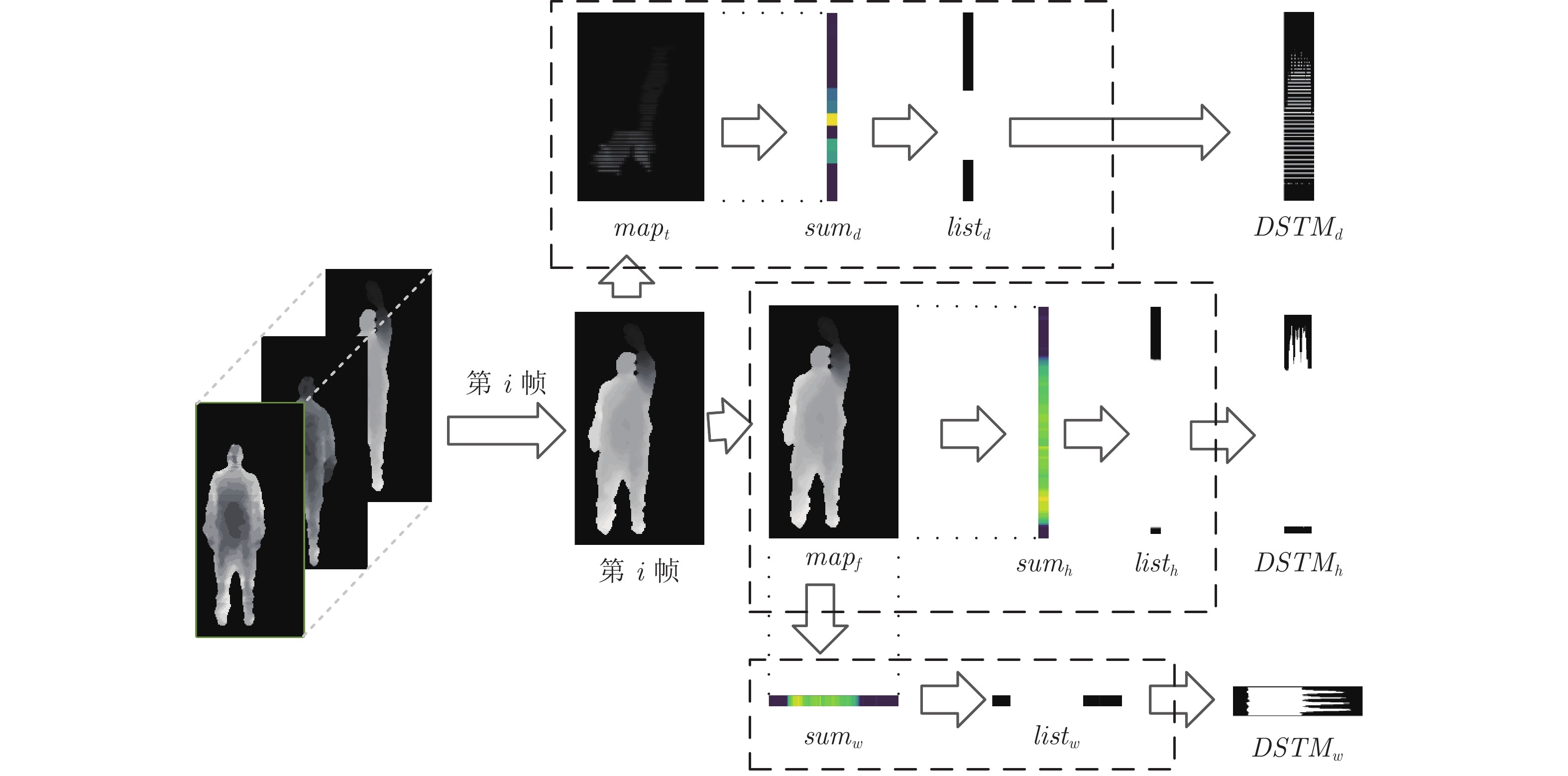

随着技术的发展, 特别是微软Kinect体感设备的推出, 基于图像序列的人体行为识别研究得到了进一步的发展. 相比于彩色图像序列, 深度图序列更有优势. 不仅可以忽略光照和背景带来的影响, 还可以提供深度信息, 深度信息表示为在可视范围内目标与深度摄像机的距离. 深度图序列相较于彩色图序列, 提供了丰富的人体3D信息, 胡建芳等[7]详细描述了RGB-D行为识别研究进展和展望. 至今已经探索了多种基于深度图序列的表示方法, 以Bobick 等[8]的运动能量图(Motion energy images, MEI)、运动历史图(Motion history images, MHI)作为时空模板的人体行为识别的特征提取方法, 提高了识别的稳健性; 苏本跃等[9]采用函数型数据分析的行为识别方法; Anderson等[10]基于3维Zerni-ke的图像数据尝试行为分类, 并且该分类对于具有低阶矩的行为是有效的; Wu等[11]基于3维特征和隐马尔科夫模型对人体行为动作进行分类并加以识别; Wang 等[12]从深度视频中提取随机占用模式(Random occupancy pattern, ROP)特征, 并用稀疏编码技术进行重新编码; Zhang等[13]使用梯度信息和稀疏表达将深度和骨骼相结合, 用于提高识别率; Zhang 等[14]从深度序列中提取的动作运动历史图像(Sub-action motion history image, SMHI)和静态历史图像(Static history image, SHI); Liu等[15]利用深度序列和相应的骨架联合信息, 采用深度学习的方法进行动作识别; Xu等[16]提出了深度图和骨骼融合的人体行为识别; Wang等[17-19]采用卷积神经网络进行人体行为识别;Yang等[20]提出了深度运动图(Depth motion maps, DMM), 将深度帧投影到笛卡尔直角坐标平面上, 生成主视图、俯视图、 侧视图, 得到三个2维地图, 在此基础上差分堆叠整个深度序列动作能量图生成DMM. DMM虽然展现出人体行为丰富的空间信息, 但是无法记录人体行为的时序信息. 针对现有深度序列特征图时序信息缺失的问题, 本文提出了一种新的深度序列表征方式, 即深度时空图(Depth space time maps, DSTM).

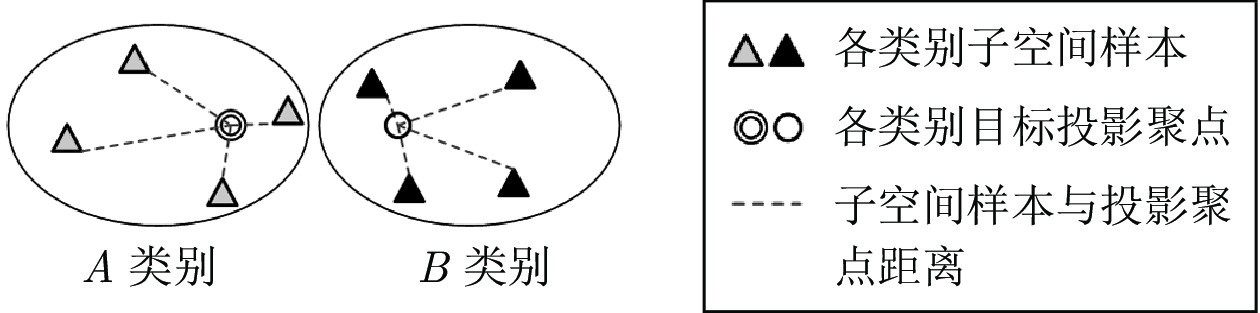

DMM侧重于表征人体行为的空间信息, 而DSTM侧重于表征人体行为的时序信息. 通过融合空间信息与时序信息进行人体行为识别, 可以提高人体行为识别的鲁棒性, 其中融合算法的可靠性直接影响了识别的精确度. 在一些实际应用中, 多模态数据虽然通过不同方式收集, 但表达的是相同语义. 通过分析多模态的数据, 提取与融合有效特征, 解决快速增长的数据量问题. 常见的融合方法有子空间学习, 例如Li等[21] 将典型性相关分析(Canonical correlation analysis, CCA)应用于基于非对应区域匹配的人脸识别, 使用CCA来学习一个公共空间, 测量两个非对应面部区域是否属于同一面部的可能性; Haghighat等[22] 改进CCA提出的 判别相关分析(Discriminant correlation analysis, DCA); Rosipal等[23] 将偏最小二乘法(Partial least squares, PLS)用于执行多模态人脸识别; Liu等[24] 的字典学习(Dictionary learning method)广泛应用于多视图的人脸识别; Zhuang等[25] 使用基于图的学习方法(Graph-based learning method)进行多模态的融合; Sharma等[26] 将线性判别分析(Linear discriminant analysis, LDA)和边际Fisher分析(Marginal Fisher analysis, MFA)扩展到它们的多视图对应物, 即广义多视图LDA (Generalized multi-view LDA, GMLDA)和广义多视图MFA (Generalized multi-view MFA, GMMFA), 并将它们应用于跨媒体检索问题; Wang等[27] 对子空间学习进行改进, 同样将它们应用于跨媒体的检索问题. 本文提出多聚点子空间学习算法以用于融合空间信息与时序信息进行人体行为识别.

图 1 DSTM流程图

图 2 单聚点子空间学习

图 3 多聚点子空间学习

针对现有的深度图序列特征图冗余过多、时序和空间信息缺失等问题, 本文提出一种新的深度序列表示方式DSTM和多聚点子空间学习, 并在此基础上进行了人体行为识别研究. 深度帧投影二值化后按时间顺序进行拼接生成DSTM, 对每张DSTM提取HOG特征以获得时序信息. 对DMM提取HOG特征以获得空间信息. 多聚点子空间学习, 在约束平衡模态间样本关系的同时, 构建同类别各样本的多个副投影聚点, 疏远不同类别样本的类间距离, 降低了投影目标区域维度, 最后送入分类器进行人体行为识别. 本实验表明本文提出的DSTM和多聚点子空间学习的方法能够减少深度序列的冗余, 保留丰富的空间信息和良好的时序信息, 有效地提高行为识别的准确性.

作者简介

杨天金

常州大学信息科学与工程学院硕士研究生. 主要研究方向为行为识别, 机器学习.E-mail: yangtianjin128@163.com

侯振杰

常州大学信息科学与工程学院教授. 2015年获内蒙古农业大学机械专业博士学位. 主要研究方向为行业识别, 机器学习. 本文通信作者.E-mail: houzj@cczu.edu.cn

李兴

常州大学信息科学与工程学院硕士研究生. 主要研究方向为行为识别, 机器学习.E-mail: lixing03201012@163.com

梁久祯

常州大学信息科学与工程学院教授. 2001年获北京航空航天大学计算机软件与理论工学博士学位. 主要研究方向为行为识别, 机器学习.E-mail: jzliang@cczu.edu.cn

宦娟

常州大学信息科学与工程学院副教授. 2019年获江苏大学农业电气化与自动化专业博士学位. 主要研究方向为信息智能处理.E-mail: huanjuan@cczu.edu.cn

郑纪翔

2020年于常州大学信息科学与工程学院获得学士学位. 主要研究方向为行为识别, 机器学习.E-mail: zjx991031@163.com

https://m.sciencenet.cn/blog-3291369-1367608.html

上一篇:采用多通道浅层CNN构建的多降噪器最优组合模型

下一篇:广义余弦二维主成分分析